Der offene Zugang zu Forschungsdaten verspricht die schnellere Generierung neuer Erkenntnisse. Eine nachvollziehbare Qualität der Daten ist dabei zentrale Voraussetzung für deren Nutzung über den ursprünglichen Verwendungszweck hinaus. Die SATW befragte im Auftrag von SWITCH Expertinnen und Experten in der Schweiz, welche Aspekte und Massnahmen dafür besonders wichtig sind.

Unabhängig vom Anwendungsbereich ist eine hohe Qualität meist eine Grundbedingung, um Daten weiter auswerten und verlässliche Voraussagen machen zu können. Damit Daten auch über den ursprünglichen Erhebungszweck hinaus wiederverwendet werden können, sollte deren Qualität nachvollziehbar dokumentiert sein. Dies ist insbesondere in der Forschung wichtig, damit das grosse Potenzial von Open Science ausgeschöpft werden kann. Welche Kriterien sind für eine nachvollziehbare Datenqualität besonders relevant und mit welchen Massnahmen wird diese sichergestellt? Dazu hat die SATW Expertinnen und Experten aus national relevanten Forschungsdomänen, der Industrie oder dem Dienstleistungssektor im Rahmen eines SWITCH Innovation Labs befragt. Die Resultate sind in einem Kurzbericht publiziert.

Forschungsdaten sind sehr heterogen und projektspezifisch. Abhängig von der Anwendung werden unterschiedliche Ansprüche an deren Qualität gestellt. Dabei verantworten die Forschenden die Datenqualität (DQ) durch Einhaltung wissenschaftlicher Standards und Richtlinien. Aus Sicht der befragten Personen hat DQ einen sehr hohen Stellenwert. Höchste Qualität zu erreichen, lässt sich allerdings meist nur mit hohem Aufwand sicherstellen, weshalb besonders in der Wirtschaft oft Qualitätsstufen definiert werden. Unklare Rahmenbedingungen im Zusammenhang mit DQ können zudem zu Mehraufwand führen. Der allgemeine Trend in der Forschung geht in Richtung mehr und frühzeitiger Berücksichtigung von DQ, zum Beispiel durch Forderungen von Forschungsförderorganisationen wie dem Schweizerischen Nationalfonds SNF.

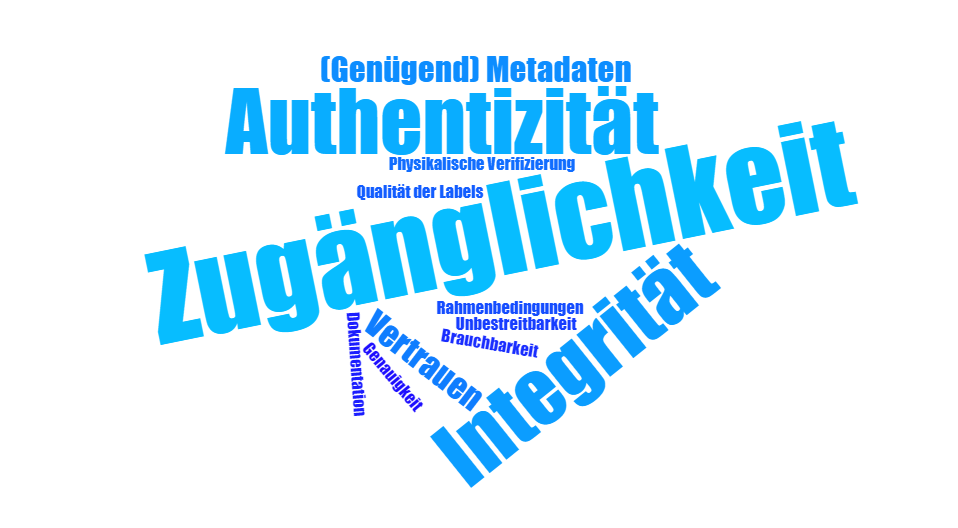

Für eine nachvollziehbare DQ sind diverse Aspekte zu berücksichtigen. Deren Relevanz hängt von der betrachteten Problemstellung ab. Die befragten Personen nannten Zugänglichkeit zu Daten am häufigsten als wichtige Voraussetzungen für eine nachvollziehbare DQ. In der Forschung ist aktuell allerdings nur ein Bruchteil der produzierten Daten zugänglich und oft mangelt es an Transparenz der vorhandenen Informationen. Um Daten zu publizieren, muss ausserdem viel Zeit für die Dokumentation aufgewendet werden.

Weitere grundlegende Aspekte für die DQ sind Authentizität, Integrität und Unbestreitbarkeit. Diese werden aber oft nur spärlich überprüft. Prozesse zur Sicherstellung der DQ wie Aufbau und Umsetzung einer Data Governance oder von Qualitätsregeln stellen grosse Herausforderungen in der Verwaltung von Daten dar. Wo möglich sollten solche Prozesse automatisiert werden. Fehlerhafte Daten und Dubletten, Aktualität, Konsistenz und Relevanz sind die spezifischen Herausforderungen im Zusammenhang mit DQ, die von den Fachleuten am häufigsten genannt wurden. Daten beschreiben die Realität nur approximativ. Daraus resultiert eine Unschärfe in deren Auswertung, was bereits bei der Erhebung berücksichtigt werden sollte. Die Aktualität der Daten sicherzustellen, ist oft schwierig und kostenintensiv.

Datenverwalterinnen und -verwalter orientieren sich an Richtlinien und Vorgaben der jeweiligen Projekte und Domänen. Standards variieren abhängig davon, ob Daten im Rahmen von Forschungsprojekten, in der Verwaltung oder in der Industrie generiert werden. Allgemein anerkannte Standards für das Datenmanagement haben sich bis heute nicht durchgesetzt. Werden Daten nicht nach standardisierten Verfahren erhoben, sind sie für Dritte kaum nutzbar. Forschende veröffentlichen meist nur aggregierte Daten, in denen die ursprüngliche Information nicht mehr vollumfänglich vorhanden ist. Die Wiederverwendung solcher Daten ist eine Herausforderung, da nicht immer klar ist, wie die Aggregation durchgeführt wurde. Eine Verpflichtung, Rohdaten aus Forschungsprojekten publizieren zu müssen, wirkt sich grundsätzlich positiv auf die DQ aus. Forschenden ist so von Anfang an bewusst, dass andere ihre Daten nutzen und allenfalls verifizieren können. Dies verbessert Dokumentation und Sorgfalt im Umgang mit Daten. Schliesslich will in der Forschung niemand kritisiert werden, mit Daten gepfuscht zu haben.

Die FAIR-Prinzipien sind Richtlinien zur Verbesserung der Auffindbarkeit, Zugänglichkeit, Interoperabilität und Wiederverwendung von digitalen Assets. Die meisten Befragten gaben an, diese zu kennen und so gut wie möglich umzusetzen. Oft werden die Prinzipien aber aus Zeitgründen vernachlässigt. Wirtschaft und Statistikämter scheinen bei der Organisation und Pflege von Daten weiter fortgeschritten zu sein und könnten in der Beziehung als Vorbild für die Forschung dienen.

Durch die zunehmende Verbreitung von Open Access und Open Data nimmt die Verfügbarkeit von Forschungsdaten seit einigen Jahren stetig zu. Viele Forschende arbeiten bislang allerdings nur mit ihren eigenen Daten, solchen von Unternehmen oder der öffentlichen Statistik. Durch Vernetzung und Nachnutzung von Forschungsdaten würden diese aber produktiver genutzt. Zudem kann dies die Visibilität der eigenen Forschung steigern und Forschende können so von den Schwerpunkten, Kompetenzen und Aufträgen ihrer Kolleginnen und Kollegen profitieren. Forschungsdaten sind allerdings sehr unterschiedlich dokumentiert und deren korrekte Interpretation kann eine Herausforderung darstellen. Der Kontext der primären Datenerhebung sollte in Metadaten festgehalten werden. Die Nutzung externer Daten setzt Vertrauen in deren Qualität und in den entsprechenden Datenlieferanten voraus. Deren Sensibilität für DQ ist zentral. Ist die Zugänglichkeit zu Daten transparent, erhöht dies das Vertrauen: Häufige Nutzung durch viele unterschiedliche Nutzerinnen und Nutzer bietet einen guten Schutz und ist ein Indiz für eine hohe DQ.

Es bestehen zahlreiche Initiativen im Bereich Open Science und Open Data. Der Erfolg dieser wird wesentlich davon abhängen, ob und wie gut die Aspekte einer nachvollziehbaren Datenqualität berücksichtigt werden. In einer Pilotphase für ein Schweizer Forschungsdaten-Konnektom will SWITCH mit Partnern Use Cases und eine mögliche Architektur validieren. Die Auffindbarkeit von Forschungsdaten wird ein zentraler Punkt sein. Die SATW wird sich dafür einsetzen, dass die Qualität der Daten von Anfang an möglichst nachvollziehbar ist. Dafür gilt es abzuklären, inwiefern einheitliche Rahmenbedingungen für Forschungsdaten entwickelt und welche Prozesse zur Sicherstellung von DQ automatisiert werden können, um Forschende zu unterstützen und zu entlasten.

Manuel Kugler, Leiter Schwerpunktprogramme Advanced Manufacturing und Künstliche Intelligenz, Tel. +41 44 226 50 21, manuel.kugler(at)satw.ch